Google introduceert Ironwood. Dat is een zelf ontwikkelde chip gebouwd rond AI-tensor-kernen en geoptimaliseerd voor inferentie in het datacenter. Ironwood is zo een alternatief voor Nvidia-chip.

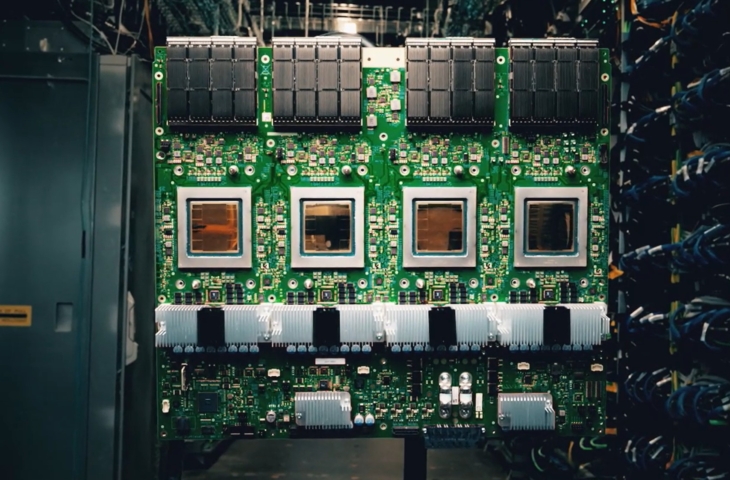

Op Google Cloud Next toont Google de Ironwood-chip. Ironwood vertegenwoordigt de zevende generatie van Tensor Processing Unit (TPU) ontwikkeld door Google zelf. TPU’s zijn chips voorzien van tensor-kernen, geoptimaliseerd voor AI-workloads.

Ironwood is speciaal ontwikkeld met inferentie in het achterhoofd. De chip is in staat stevige AI-modellen te laden en te gebruiken. Iedere Ironwood-chip heeft daarvoor 192 GB aan High Bandwith Memory (HBM) aan boord. Dat is zes keer meer dan voorganger Trillium. De HBM-bandbreedte per chip is bijna verdubbeld, van 4,5 TBps voor Trillium tot 7,2 TBps voor Ironwood.

Clusters

Google gaat de chips beschikbaar stellen via clusters in de cloud. Die komen in twee maten. In de instapversie combineert Google al 256 Ironwood-chips, wat de facto al een HPC-cluster is dat inferentie op schaal kan ondersteunen.

Mag het allemaal wat meer zijn, dan voorziet Google ook ‘pods’ van 9.216 Ironwood-chips. In die configuratie levert het systeem volgens Google 42.5 ExaFlops (FP8) op. Google claimt dat de pod sneller is dan El Capitan, maar die claim slaagt op niets: ’s werelds snelste supercomputer is wel degelijk minstens dubbel zo performant. We nemen wel aan dat een 9.216 chips-tellend Ironwood-cluster bijzonder krachtig is voor AI-inferentie op schaal.

Optimalisatie

Ironwood kan niet alleen moderne LLM’s ondersteunen, maar is ook geoptimaliseerd voor meer klassieke AI-workloads. Denk daarbij aan recomendation engines: de systemen die in staat zijn om gepersonaliseerde aanbiedingen op webshops te genereren. De ingebouwde SparceCore is een accelerator speciaal voor dergelijke taken.

Google stipt nog de efficiëntie van Ironwood aan. De chip levert 29,3 Flops per Watt, waar dat bij Trillium nog maar 14,6 was. Google verklapt al een tijdje niet meer publiek wie de TPU’s bakt of op welke node. Gezien de efficiëntie gaat het vermoedelijk om een actuele proces-node bij een belangrijke fabrikant zoals TSMC.

Eigen chips

Alle grote cloudspelers sleutelen aan hun eigen chips. Google was er snel bij met zijn Tensor-accelerators, maar ook AWS heeft intussen een groot portfolio. Denk aan de Gaviton-cpu’s, de Trainium-trainingschips en de Inferentia-inferentie-accelerators. Voor Microsoft gaat het om Maia.

Met eigen (AI-)chips kunnen cloud providers proberen om een duidelijker verschil te maken tussen hun aanbod en dat van de concurrentie. Bovendien bouwen ze zo de afhankelijkheid af van Nvidia’s erg dure chips, die bovendien niet altijd vlot beschikbaar zijn. Ironwood is zo een troef voor Google naar klanten toe, alsook een verzekering tegen Nvidia-dominantie.