Nvidia lanceert het Rubin-platform. De Rubin-chip volgt Blackwell op en zal vanaf de tweede helft van dit jaar nieuwe en krachtige AI-systemen aandrijven, samen met de Vera-CPU.

Op CES lanceert Nvidia zoals gepland de Rubin-chip. Rubin volgt Blackwell op en moet vijf keer beter presteren dan zijn voorganger op het vlak van inferentie. Rubin bevat 336 miljard transistors, goed voor 50 petaflops aan NVFP4-rekenkracht. De verwerkingssnelheid voor training van AI-modellen is iets lager met 35 petaflops, wat zo’n 2,5 keer meer is dan Blackwell.

Platformaanpak

De nieuwe chip maakt deel uit van wat Nvidia het Rubin-platform noemt. In dat platform zit ook de nieuwe ARM-gebaseerde Vera-CPU. Die omvat 88 Olympus-kernen, ontwikkeld door Nvidia zelf en compatibel met Armv9.2. De chip vertrouwt op NVLink-C2C als interconnect. De naam van beide chips is afkomstig van Vera Florence Cooper Rubin: een Amerikaanse astronome.

Nvidia combineert de Rubin-accelerator en de Vera-CPU tot Vera Rubin: een tandem die Grace Hopper opvolgt. Vera Rubin NVL72 is een volledig serverrek waarin de hardware tot een AI-HPC-systeem wordt gecombineerd. De onderdelen van het rek praten met elkaar via de zesde generatie van NVLink. Ook de ConnectX9-SuperNIC, een netwerk-accelerator, maakt deel uit van het ontwerp, samen met de BlueField-4-DPU.

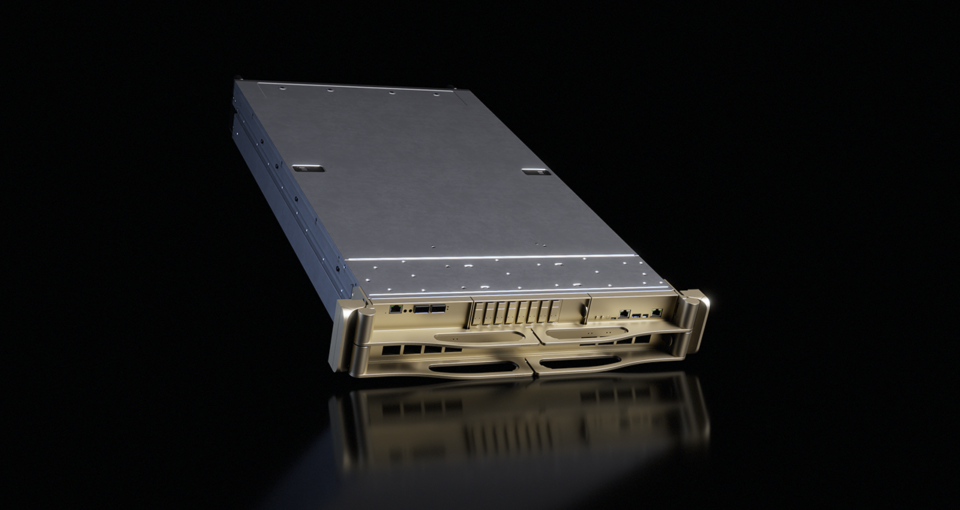

Nvidia verpakt Rubin ook in een kleiner systeem: DGX Rubin NVL8. Dat is een klassiekere server met acht Nvidia Rubin-GPU’s aan boord, gecombineerd met dual socket Intel Xeon 6776P-CPU. De x86-gebaseerde

SuperPOD

Tot slot voorziet Nvidia de architectuur om Vera Rubin NVL72 of DGX Rubin NVL8 op grote schaal uit te rollen en te combineren tot clusters. Dat gebeurt via Nvidia DGX SuperPODs. Een enkele Nvidia DGX SuperPOD kan acht Nvidia DGX Vera Rubin NVL72-rekken ommvatten, of 64 DGX Rubin NVL8-servers.

Nvidia richt zich met Rubin opnieuw op de grote AI-producenten van deze wereld. Onder andere OpenAI, Microsoft, AWS en Google zitten op de krachtige hardware te wachten, net als Meta en Oracle. Ook fabrikanten waaronder HPE, Dell en Lenovo willen Rubin omarmen.

lees ook

Wie gaat AI-serverracks van 1 MW koelen en voeden (en hoe)?

Nvidia claimt een hogere efficiëntie met de nieuwe componenten. De prijs per inferentietoken zou met factor tien dalen tegenover de vorige generatie. Terzelfdertijd maakt Rubin een hogere dichtheid van systemen mogelijk. Watergekoelde clusters met vermogens per rek van 200 watt komen met deze hardware in het vizier. De honger naar meer AI-rekenkracht en bijgevolg meer stroom, zal met de introductie van Rubin niet gaan liggen.

De Rubin-chips zouden op dit moment in volume van de band rollen. De eerste oplossingen met Rubin aan boord moeten via partners beschikbaar komen in de tweede helft van 2026. Alle grote cloudproviders plannen nog dit jaar Vera Rubin-instances op het menu te zetten.