Cloudera maakt het met de nieuwste release van Data Services mogelijk voor organisaties om binnen het Cloudera-ecosysteem generatieve AI in het eigen datacenter uit te rollen.

Cloudera introduceert met zijn nieuwste release van Cloudera Data Services Private AI on-premises. Daarmee stelt het bedrijven in staat om generatieve AI uit te rollen binnen het eigen datacenter, achter de firewall.

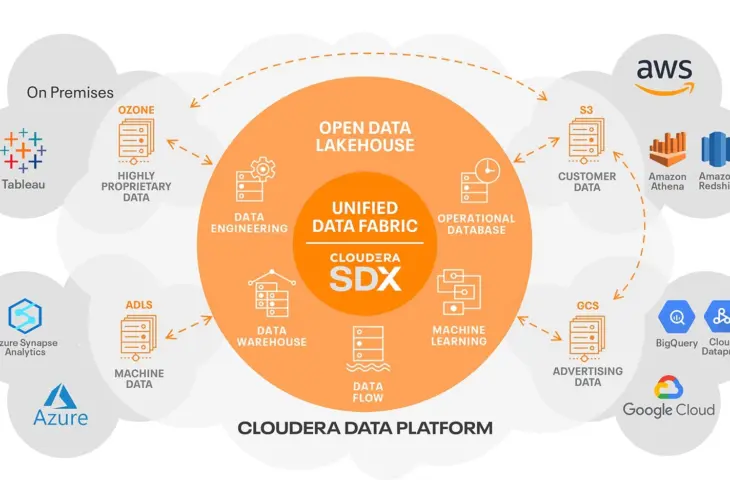

Dit biedt meer controle over beveiliging, data-integriteit en intellectueel eigendom, klinkt het. De nieuwe diensten draaien op GPU-versnelde infrastructuur en maken gebruik van cloud-native technologie, zonder dat data naar de publieke cloud moet verhuizen. Cloudera wil bedrijven die mogelijkheden zelf bieden, zodat zich niet laten verleiden om het Cloudera-ecosysteem te verlaten.

Van cloud naar on-prem

De release bevat onder meer Cloudera AI Inference Services en Cloudera AI Studios, die nu ook on-premises beschikbaar zijn. Beide oplossingen waren voorheen enkel in de cloud toegankelijk. De AI Inference Service is gebouwd met technologie van Nvidia en helpt bij het implementeren en beheren van AI-modellen in productie. AI Studios richt zich op het ontwikkelen van GenAI-toepassingen via low-code templates, zodat ook minder technische teams aan de slag kunnen.

De tools draaien in het datacenter van de klant, waar de data al aanwezig is. Dat vermindert risico’s rond gegevensbescherming en maakt het mogelijk om gevoelige AI-toepassingen te ontwikkelen zonder externe afhankelijkheden. De schaalbaarheid blijft behouden dankzij de cloud-native architectuur die nu lokaal inzetbaar is.

Cloudera wil met deze release tegemoetkomen aan de groeiende vraag naar AI binnen een gecontroleerde, lokale omgeving. Het bedrijf wil ook binnen die context een belangrijke rol spelen.