AI kan de katalysator worden van een fundamentele verschuiving in de technologie-industrie. En volgens Arm ligt de sleutel tot die toekomst in inference, niet in training – en vooral aan de edge.

“Dit is geen gewoon jaar”, steekt Chris Bergey, SVP en GM van Client Line of Business bij Arm van wal tijdens zijn keynote op Computex in Taiwan. “We staan aan de vooravond van het belangrijkste moment in de technologiegeschiedenis.” In zijn ogen is AI niet langer een buzzwoord, maar een realiteit die alle sectoren hertekent. “Elke productbeslissing is vandaag een AI-beslissing. Elk team is een AI-team geworden.”

Wat hem vooral fascineert, is het tempo waarmee AI zich ontwikkelt. Meer dan 150 nieuwe foundation models zijn de afgelopen 18 maanden gelanceerd, elk met accuraatheden boven de 90 procent. “We zijn geëvolueerd van simpele prompts naar multimodale interacties, en zelfs naar fysieke AI-toepassingen. De opmars is duizelingwekkend,” zegt Bergey.

Van cloud naar edge: inference als sleutel tot schaal

Toch stelt hij dat de echte commerciële waarde van AI niet ligt in het trainen van die modellen – hoe indrukwekkend dat ook is – maar in inference, en meer specifiek: inference aan de edge. “Training vergt immense rekenkracht, maar inference bepaalt of je waarde creëert. Die moet snel, energie-efficiënt én overal beschikbaar zijn.”

Training vergt immense rekenkracht, maar inference bepaalt of je waarde creëert.

Chris Bergey, SVP en GM van Client Line of Business bij Arm

Latency is volgens Bergey dé reden waarom inference naar de edge verhuist. “AI-assistenten die real-time reageren, kunnen zich niet veroorloven om telkens naar de cloud te gaan.” Daarnaast speelt kostenefficiëntie een steeds grotere rol. “Edge inference maakt AI toegankelijk voor toepassingen op consumentenniveau, zonder afhankelijk te zijn van datacentercapaciteit.”

Als voorbeeld verwijst hij naar Ray-Ban’s AI-gestuurde brillen in samenwerking met Meta die in Europa heel goed verkopen. “Wat zes maanden geleden sciencefiction leek, is vandaag een retailproduct.”

AI vergt nieuwe infrastructuur

De verschuiving richting edge heeft grote implicaties voor de infrastructuur. In een aparte vragenronde met de pers onderstreept Bergey dat legacy-architecturen zoals x86 niet ontworpen zijn met AI in gedachten. “Ze zijn gebouwd voor webservers, niet voor workloads die ExaFLOPS vergen.” Volgens Arm is het tijdperk van schaalvergroting via meer racks voorbij. “We moeten meer doen met minder watt per FLOP.”

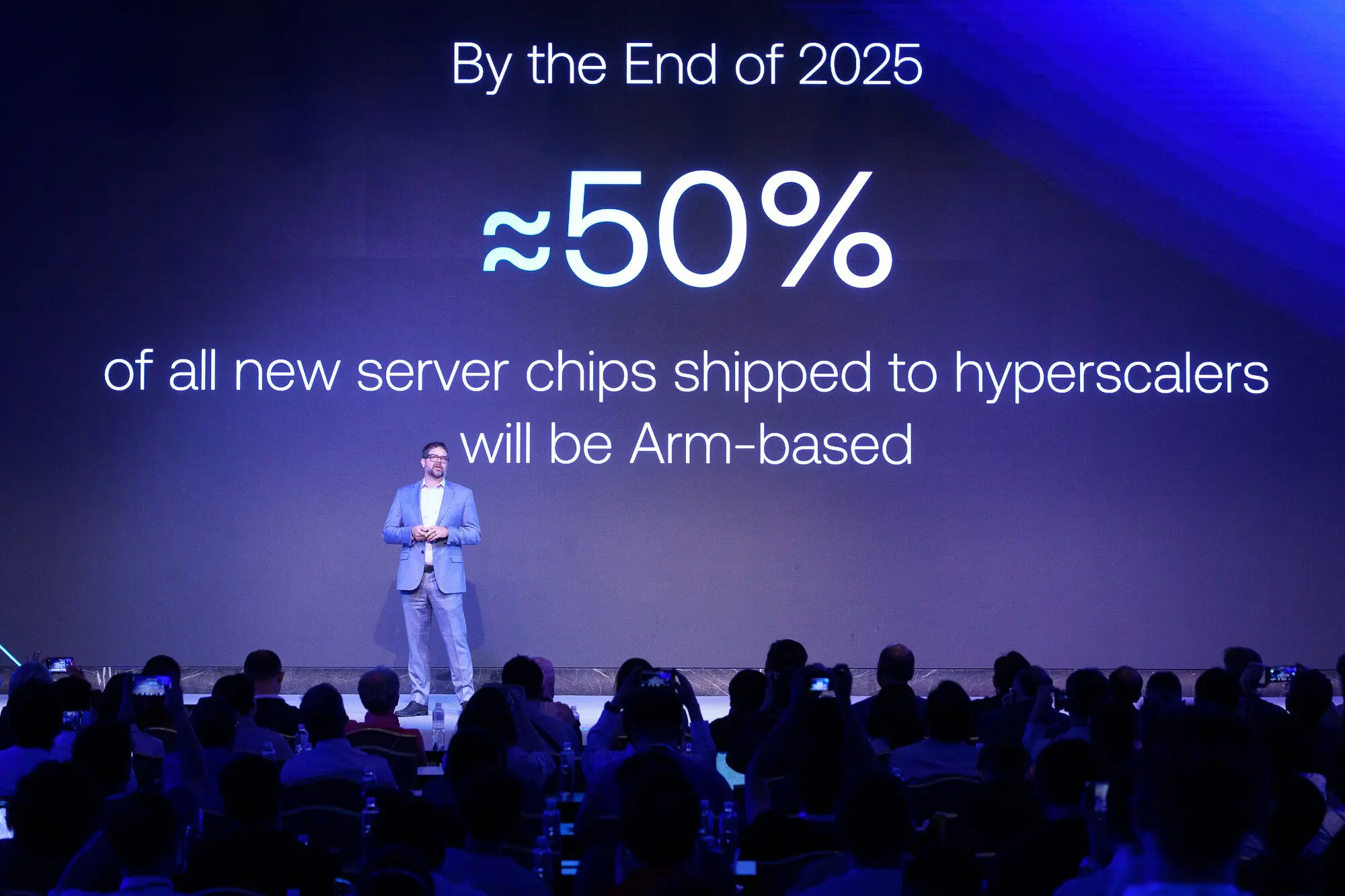

Bergey haalt aan dat hyperscalers dat beseffen. AWS zou volgens cijfers van Arm meer dan 50 procent van de recent toegevoegde CPU-capaciteit gebaseerd zijn op Arm-architectuur via eigen Graviton-chips. Ook Microsoft, Google, Oracle en Alibaba zetten massaal in op Arm-chips voor hun eigen en derdepartij AI-workloads.

Een platform, geen chipfabrikant

Opvallend tijdens de vragenronde met de pers was Bergey’s duidelijke positionering van Arm binnen het AI-ecosysteem. Hoewel Arm IP levert aan onder andere Nvidia (DGX Spark, Grace Blackwell), benadrukt hij dat het bedrijf géén chipfabrikant wil worden. “Onze rol is om het ecosysteem te ondersteunen, niet om ermee te concurreren.”

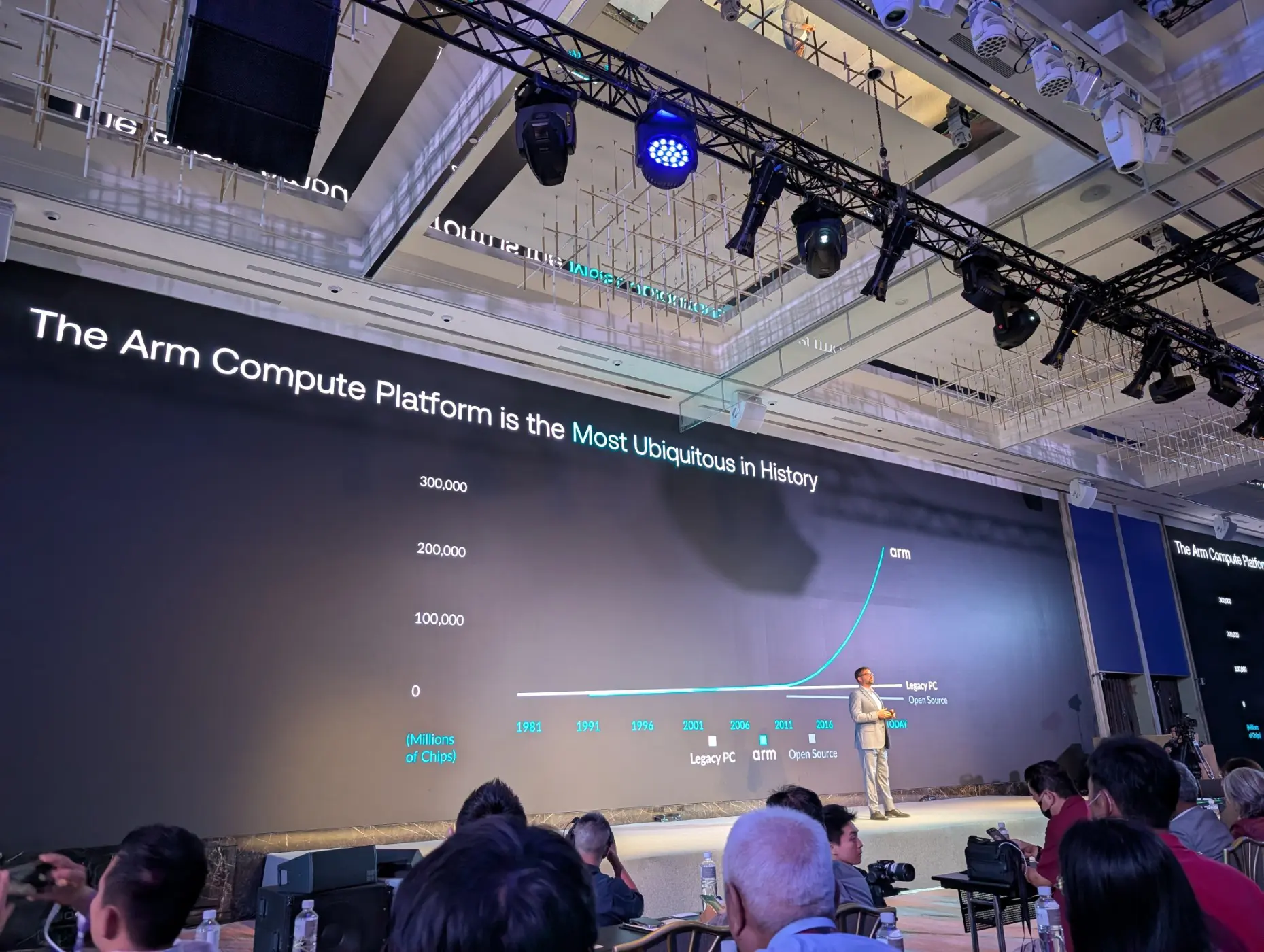

Arm blijft vasthouden aan zijn ‘partner-first’-model. Het bedrijf levert IP en ontwikkeltools die door partners als MediaTek, AWS, en Qualcomm gebruikt worden om hun eigen oplossingen te bouwen. “Wij zorgen dat ontwikkelaars kunnen bouwen op een consistente, schaalbare en energie-efficiënte basis, van wearables tot AI-supercomputers,” aldus Bergey.

Over het gerucht dat Arm aan eigen chips werkt om te concurreren met de hyperscalers, wordt gezwegen tijdens Computex. Het bedrijf zou naar verluidt Meta al overtuigd hebben om de chip af te nemen. Gezien de expertise van Arm, en de ambities van Meta, betreft de eigen component vermoedelijk een CPU voor servers.

Kleidi: versnellen op schaal

Een van Arm’s troeven daarbij is Kleidi, een AI-acceleratielaag die vorig jaar op Computex werd bekend gemaakt. Volgens Bergey werd die in één jaar tijd al acht miljard keer geïnstalleerd. Kleidi is geïntegreerd in frameworks als ONNX (Microsoft), LiteRT (Google), ExecuTorch (Meta) en Angel (Tencent), en zorgt ervoor dat AI-workloads meteen optimaal draaien op Arm-gebaseerde hardware.

“Kleidi toont wat er mogelijk is als je AI-versnelling slim inbouwt in de softwarestack. En het bewijst dat wij niet alleen een hardwarebedrijf zijn, maar een volwaardig platform,” zegt Bergey.

Nu hyperscalers de weg vinden naar Kleide, is de kans groot dat alles in een stroomversnelling zal komen voor Arm.

AI-infrastructuur moet hertekend worden

Bergey waarschuwt ook voor een valkuil: “We kunnen praten over de belofte van AI, maar zonder energie-efficiënte infrastructuur zal AI nooit op schaal uitgerold raken.” Hij benadrukt dat GPU’s essentieel blijven, maar dat CPU’s een bottleneck worden als ze de datastroom richting GPU’s niet kunnen bijbenen.

De oplossing? Nieuwe, gebalanceerde systemen waarin CPU, GPU en eventueel NPU nauwer samenwerken. “Wat Nvidia deed met Grace Blackwell toont die richting. Maar ook bij andere hyperscalers zie je co-design van custom silicon opduiken.”

Het spreekt voor zicht dat Bergey overal Arm in het hart ziet in al die ontwerpen. Hoe minder x86, hoe beter voor hen.

Tot slot: momentum en maturiteit

Chris Bergey sluit af met een duidelijke boodschap: AI is overal – maar Arm wil ervoor zorgen dat AI ook overal kán draaien: in edge-toestellen, in de cloud, in wearables, in datacenters. “We zijn geen hype meer aan het najagen. We bouwen de fundering waarop deze nieuwe golf aan intelligentie kan draaien.”

AI heeft het speelveld veranderd. En Arm heeft het bord mee ontworpen.

Chris Bergey, SVP en GM van Client Line of Business bij Arm

Met AI als drijvende kracht en inference als basis om geld te verdienen, profileert Arm zich als de stille motor van de AI-revolutie. Niet met flashy demo’s, maar met schaalbare, energie-efficiënte technologie die anderen toelaat om te innoveren.

Of zoals Bergey zegt: “AI heeft het speelveld veranderd. En Arm heeft het bord mee ontworpen.”